AIで"似ている画像"を見つけよう!

2025/06/16

1. はじめに

製造業の現場では、画像認識AIの導入が急速に進んでいます。不良品の検出、部品の照合、工程の監視など、画像をもとに判断を下す作業はこれまで熟練作業者の目に頼っていましたが、近年ではAIがその一部を代替できるようになってきています。

こうした画像認識AIの核となるのは、「画像をどのようにして意味のある情報として捉えるか」です。従来は、CNN(畳み込みニューラルネットワーク)ベースのアルゴリズムを使って、画像を分類したり異常を検出したりする方法が主流でした。しかし、最近登場したマルチモーダルな大規模言語モデル(Multimodal LLM)は、「画像を文章と同じように理解し、意味的に近い画像を探す」ことができると注目を集めています。

たとえば、「ある部品の画像をもとに、似たような形状の部品を自動でピックアップしたい」というニーズは現場でしばしば生じます。従来は人の目で一つずつ確認したり、ルールベースの画像検索で対応したりしていましたが、画像の構図や光の当たり方が変わると精度が落ちてしまうという課題がありました。

そこで本記事では、「マルチモーダルLLMを使えば、意味的に似た画像をもっと高精度に、柔軟に検索できるのか?」という問いを出発点に、実際に画像を埋め込んでベクトルに変換し、コサイン類似度を用いて類似画像を検索する技術検証を行います。

この取り組みによって、製造現場でのAI活用がさらに一歩進むかもしれません。技術的な限界や可能性を探るとともに、実運用へのヒントとなることを目指して、詳しく検証していきます。

2. 技術背景

画像認識AIの性能を左右する要素のひとつが、「画像をどのように数値データに変換して、比較・分析できる状態にするか」です。人間が見たときに「似ている」と思う2枚の画像でも、コンピュータにとっては単なるピクセルの集合であり、意味のある“類似性”を測るのは意外と難しい問題です。

埋め込みベクトル

そこで登場するのが、「埋め込みベクトル(embedding vector)」という考え方です。これは、画像を高次元のベクトル(数値の並び)として表現するもので、意味的に似た画像ほど“近い位置”に変換されるように学習された空間です。埋め込みベクトルを使えば、画像同士の「意味的な距離」を比較できるようになります。

従来、このようなベクトル化は、冒頭で触れたCNNベースのモデル(ResNetやEfficientNetなど)や、画像検索専用のネットワークを用いて行っていました。しかし、最近ではOpenAIの「CLIP」や、Metaの「BLIP」のようなマルチモーダルモデル、さらにはGPT-4oのようなマルチモーダルLLM(Large Language Model)が注目を集めています。

これらのモデルは、テキストと言語を同じ次元で扱えるように訓練されており、画像と文章を一つの“意味空間”にマッピングする能力を持ちます。つまり、「この画像に写っているものと似たものを探したい」という人間の感覚により近い形で、画像の意味を理解し、ベクトルに変換してくれるのです。

コサイン類似度

そして、このベクトル同士の“近さ”を測る方法としてよく使われるのが「コサイン類似度(cosine similarity)」です。これは、2つのベクトルがどのくらい同じ方向を向いているかを測る指標で、1に近いほど似ているとされます。

簡単にいえば、

画像 → 埋め込みベクトルへ変換 →コサイン類似度により 他の画像とベクトル同士を比較 → 類似度が高い順に並べる

という流れです。

本コラムでは、このマルチモーダルモデルによるベクトル変換と、コサイン類似度を使った検索手法の実力を検証してみたいと思います。

3. 技術検証

今回は、OpenAIが提供するCLIP(Contrastive Language–Image Pre-Training)モデルを用いて、簡単な類似画像検索の検証を行いました。

用意したのは、以下の4枚の画像です。なお、画像はCOCOデータセットより取得しています。

猫の画像 × 2枚

犬の画像 × 2枚

cat1.jpg

cat2.jpg

dog1.jpg

dog2.jpg

これらの画像をCLIPモデルを使って埋め込みベクトル(512次元)に変換し、各ベクトル同士のコサイン類似度を計算しました。

その結果、次のような傾向が見られました。

cat1.jpg | cat2.jpg | dog1.jpg | dog2.jpg | |

|---|---|---|---|---|

cat1.jpg | 1.000 | 0.742 | 0.559 | 0.667 |

cat2.jpg | 0.742 | 1.000 | 0.672 | 0.660 |

dog1.jpg | 0.559 | 0.672 | 1.000 | 0.712 |

dog2.jpg | 0.667 | 0.660 | 0.712 | 1.000 |

特筆すべきは、同じカテゴリ(猫同士・犬同士)での類似度が高く、異なるカテゴリ間では低下するという結果です。CLIPは「画像そのもののピクセルの近さ」ではなく、「画像が意味する内容」をベースにベクトルを生成しているため、このように動物種の違いを捉えることができています。

この結果から、CLIPのようなマルチモーダルモデルは視覚的な特徴だけでなく、意味的な類似性を捉えることにも長けていることが確認できました。製造現場においても、「見た目が微妙に異なるが意味的には同じ部品」や、「構造が似ている異形部品」などの識別に応用できる可能性があると感じられる結果です。

4. 応用の展望

今回の検証から、CLIPのようなマルチモーダルモデルは、画像の意味的な特徴を捉えて類似度を計算できることが確認できました。単なるピクセルレベルの一致ではなく、「何が写っているか」「どんな雰囲気か」などの情報をベクトルとして表現できるため、応用の幅は非常に広いと考えられます。

製造業における活用可能性

類似部品の照合や代替候補の検索

たとえば「この部品に似ているが型番が違うもの」を探す場面では、従来は目視確認やルールベースの類似検索が必要でした。CLIPのようなモデルを使えば、意味的に近い部品を自動で抽出でき、作業の効率化や属人性の排除に繋がります。

不良品の検出と原因追跡

正常品と不良品の埋め込みベクトルを比較することで、「不良品がどのように正常品と異なっているか」を数値として可視化することができます。特に、外観検査で微細な形状変化や汚れを検出したい場合に有効です。

過去事例ベースのノウハウ活用

たとえば、修理記録やトラブル対応履歴と照らし合わせて「似たような見た目の事例」を検索することで、ベテラン技術者の知見をAIで再現する足がかりにもなります。

今後の技術展開に向けて

マルチモーダルLLMは、今後さらに高精度・低コスト化が進むことが予想されます。特に、

エッジデバイスでの軽量モデル展開

⇒ 工場の端末やローカル設備に直接AIを組み込むことで、クラウド接続不要でリアルタイム判定が可能に。

テキストやセンサーデータとの融合によるマルチ入力判断

⇒ 画像だけでなく温度・音・ログ情報と組み合わせて、より精緻な異常検知や工程分析が実現できる。

ファインチューニングによる現場特化モデル

⇒ 自社の製品や部品に特化した学習を行うことで、現場独自の“判断基準”をAIが理解しやすくなる。

といった方向に進化すれば、画像認識AIの現場適用はさらに加速するでしょう。

5.まとめ

本コラムでは、マルチモーダルなモデルであるCLIPを用いて、画像をベクトル化し、コサイン類似度により類似画像を検索する技術の検証を行いました。

検証の結果、以下のようなポイントが明らかになりました。

画像の意味的な類似性を数値で捉えることが可能であり、カテゴリが異なる画像でも構図や雰囲気が近いものは「似ている」と判断される

猫と猫、犬と犬といった同一カテゴリ間では高い類似度が得られ、CLIPの意味理解能力の高さが確認できた

この技術は、製造現場における部品照合・不良品検出・ナレッジ検索といった多くの業務に応用可能

単なる画像認識から一歩進んで、「画像の意味を捉えるAI」が現場で活躍する時代が近づいています。もちろん万能というわけではなく、CLIPは一般向けに訓練されたモデルであるため、現場固有の文脈や表現には対応しきれない部分もあります。

しかし、「今あるデータで試せる」「汎用モデルの割に精度が高い」「追加の教師データがなくても意味理解ができる」という点で、まずは試してみる価値がある技術であることは間違いありません。

現場の知恵とAIを組み合わせて、新たな製造DXの一歩を踏み出してみてはいかがでしょうか。

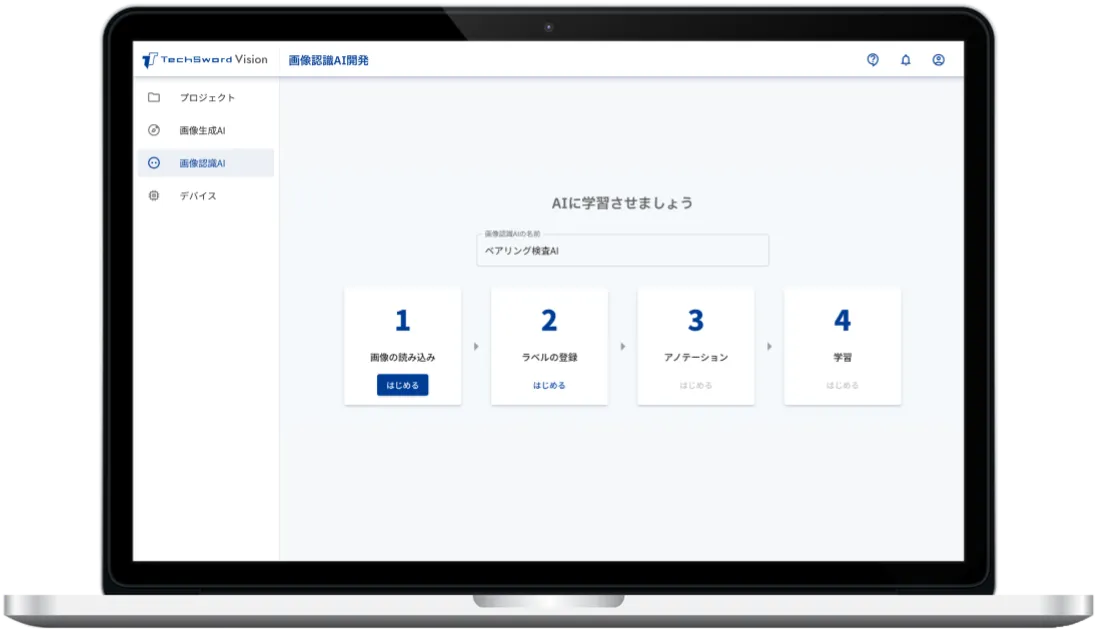

ノーコードAI 開発ツール「TechSword Vision」

TechSword Visionは誰でも簡単にノーコードで画像認識AIを開発し、現場のエッジデバイスに簡単なマウス操作でインストールが可能なノーコードAIプラットフォームです。

ソフトウェアはサブスクリプションで提供しております。

導入にあたっては、画像の撮影や収集、カメラの選定、システム導入後の運用支援やメンテナンスに至るまで幅広いサポートをおこなっております。

AIエンジニアの稼働が必要ないため初期コストも小さく、新たにAIによる画像検査の導入を検討している場合に特におすすめです。

ご興味がある場合は、ぜひ詳細なサービス説明資料をご請求ください。

また、具体的な導入事例や導入後の流れについても、ご希望に応じて説明させて頂きます。ぜひお気軽にお問い合わせください。