「OCRか?物体検出か?」迷えるあなたに贈る、画像認識AIの選び方

2025/04/23

「文字を読むAI」と「モノを見つけるAI」、あなたの現場に必要なのはどっち?似ているようでまったく違う、「OCR」と「物体検出」の違いと現場に合った選び方を、現場目線でわかりやすく解説します。

- なぜ「OCR vs 物体検出」を比較するのか?

- 用途・入出力の違いを整理(OCRと物体検出の基本)

- OCR(Optical Character Recognition)とは?

- 物体検出(Object Detection)とは?

- 用途から見る違い

- 判断のヒント:「何を知りたいのか?」

- 内部構造は“ブラックボックス”でOK——ユーザー視点で押さえる2つのポイント

- ポイント1:AIは“見たまま”を判断する

- ポイント2:学習データがすべての基準になる

- 評価指標と“精度”の考え方

- OCRの精度指標

- 代表的な指標

- 物体検出の精度指標

- 代表的な指標

- 「100%」の精度って目指せるの?

- 現場ニーズから考える「OCRか物体検出か」の選び方

- パターン①:ラベルの文字を読みたい

- パターン②:部品があるかどうかを確認したい

- パターン③:「ラベルが貼ってあるかどうか、そのうえで内容も確認したい」

- パターン④:異物混入や欠陥を見つけたい

- パターン⑤:レーザーマーキングのかすれた品番

- パターン⑥:ラベルが貼られている“位置の正しさ”を検査したい

- パターン⑦:2次元コードの“存在確認”だけしたい

- 迷ったときの判断基準:「出力の形式」に注目

- 導入・運用の勘どころ(照明・エッジ vs サーバなど)

- ポイント①:照明は“AIの眼鏡”になる

- ポイント②:処理環境の選定(エッジ or サーバ)

- エッジ処理(例:Jetsonなど)

- サーバ処理(クラウドやオンプレ)

- ポイント③:誰が運用するのか?を最初に決める

- まとめ

- OCRと物体検出の違い:要点まとめ

- まずは「何を出力させたいか?」を考える

- TechSword Vision のご紹介

なぜ「OCR vs 物体検出」を比較するのか?

「OCRと物体検出、どっちが自分たちの現場に合っているのかわからない」

画像認識AIを導入する際、多くの現場でそんな声を聞きます。対象物をカメラで撮影し、そこから「何が写っているか」をAIに判断させる。この工程でよく使われるのが「OCR(文字認識)」と「物体検出(Object Detection)」の2つの技術です。

両者は画像から情報を取り出すという点では似ていますが、実際の使いどころや得意な処理はまったく異なります。にもかかわらず、「名前は知っているけど違いはよく分からないまま導入してしまった」というケースも少なくありません。

結果として、思ったような精度が出なかったり、あとから手戻りが発生したりすることも。

この記事では、OCRと物体検出の違いを、仕組みや用途、出力される情報の観点から整理し、どのような場面でどちらを選ぶべきかをわかりやすく紹介します。

AIは魔法ではありませんが、適材適所で使えば心強い味方になります。迷わず進めるように、基本の見極め方からしっかり押さえていきましょう。

用途・入出力の違いを整理(OCRと物体検出の基本)

まずは、「OCR」と「物体検出」がそれぞれ何をする技術なのかを整理しましょう。

OCR(Optical Character Recognition)とは?

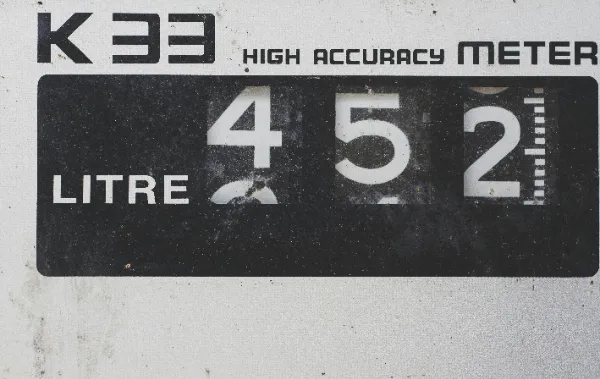

OCRとは「光学文字認識」のことで、画像や映像の中に写っている文字を読み取り、テキストデータとして出力する技術です。たとえば、部品に印字された品番やロット番号、ラベルの文字などを読み取る場面で活用されます。

入力: 画像(静止画または映像)

出力: テキスト情報("AB1234"など)

OCRが得意なのは「文字が一定の位置・大きさ・フォントで、明瞭に写っている」場合です。逆に、傾いていたり、印字がかすれていたり、背景とコントラストが弱かったりという場合は精度が落ちやすいという弱点があります。

物体検出(Object Detection)とは?

物体検出は、画像の中にある対象物を見つけ出し、それが「どこに」「何個」あるのかを判定する技術です。画像中の対象物に枠(バウンディングボックス)を描いて、その位置とカテゴリを出力します。部品の有無や異物の検出、ラベルの貼り忘れの確認などに使われます。

入力: 画像(静止画または映像)

出力: 座標付きの検出結果("ラベルあり [x=120, y=75, w=50, h=20]"など)

物体検出は「どこにあるか」に強い技術なので、位置・形・個数が関係するタスクに向いています。一方で、文字の細かい読み取りや誤字脱字の検出には向いていません。

用途から見る違い

比較項目 | OCR | 物体検出 |

|---|---|---|

認識対象 | 文字 | モノ(物体・領域) |

出力形式 | テキスト | 位置付きの検出結果 |

用途例 | 品番読み取り、日付チェック、ラベル文字認識 | 部品有無、異物検知、ラベル貼付確認 |

判断のヒント:「何を知りたいのか?」

この2つを使い分ける際の判断軸はシンプルです。

「何と書いてあるか」知りたいならOCR

「何があるか」「どこにあるか」知りたいなら物体検出

ただし、現場では「ラベルがあるか」を物体検出で確認し、「そのラベルの内容は何か」をOCRで読む、という併用パターンも非常に多く見られます。

次章では、こうした技術の裏側にある“しくみ”を、なるべく専門用語を避けつつ、現場目線で解説していきます。

内部構造は“ブラックボックス”でOK——ユーザー視点で押さえる2つのポイント

「AIのしくみは難しそう」「ディープラーニングって結局なに?」

そう感じる方も多いかもしれませんが、実は、画像認識AIを使うにあたって“中のアルゴリズムを理解している必要はほとんどない”というのが現実です。

それよりも重要なのは、「そのAIがどう動くか」「何を入力したら、どんな出力が返ってくるか」、そして「精度に影響するポイントは何か」という、技術の利用者としての理解です。

OCRと物体検出に共通して、AI技術を利用する上でユーザーが押さえておくべきポイントを2つ紹介します。

ポイント1:AIは“見たまま”を判断する

AIは“画像の中にある情報”だけを使って判断します。これは、OCRでも物体検出でも同じです。

そのため、例えば

OCRの場合、印字がかすれていたり、照明が不均一で影になっていると、文字が読み取れません。

物体検出の場合、対象物が画角の外にあったり、背景と同化していたりすると、そもそも「そこにある」と認識できません。

つまり、AIの精度は「写真の良し悪し」に大きく左右されるということです。人間なら「これは写りが悪いけど文字だな」と類推できますが、AIはそこまで気が利きません。

照明やカメラ位置など、“AIが見やすい環境づくり”が、実は最も重要な運用ポイントなのです。

ポイント2:学習データがすべての基準になる

2点目は、「AIは学習したことしかわからない」ということです。

OCRモデルは、あらかじめ大量の“文字が写っている画像”を学習して「これはA、これはB」と覚えています。物体検出モデルも、「この形はボルト」「この形はキャップ」といった画像を繰り返し見て学んでいます。

このため、実際の現場で使う画像と、学習に使った画像の条件が違うと、「見たことがない」「知らない」ものとして、正しく判断できないリスクが高くなります。

例えば、学習では白バックの画像だったのに、実際の運用では黒いトレーの上で検査する——この程度の違いでも結果に影響します。

そのため、「学習データをどう用意するか」「現場の環境と近いかどうか」が、AI導入の成否を分けるカギとなります。

次章では、こうした“精度”をどう測るか?について、製造業でもよく使われる指標をもとに解説していきます。

評価指標と“精度”の考え方

「精度は何パーセントくらい出ますか?」 AI導入の初期段階でよく聞かれる質問です。

しかし一口に“精度”といっても、実は1つの数字では語れません。 OCRと物体検出では、精度の意味も測り方も違うからです。 ここでは、よく使われる評価指標と、それぞれの意味合いについて整理してみましょう。

OCRの精度指標

OCRでは、画像からテキストをどれだけ正しく読み取れたかを評価します。

代表的な指標

文字誤り率(Character Error Rate: CER)

正しい文字数に対して、誤認識・挿入・削除された文字の割合。

値が小さいほど優秀。

単語誤り率(Word Error Rate: WER)

単語単位で誤りをカウントする評価法。文章を読むOCRに適している。

例えば「AB1234」というラベルを「AB123」と認識してしまった場合、1文字の削除でCERは約17%。

OCRでは、「どこが間違っているか」が重要になるため、実用上は「品番全体が正しく読める割合」のような独自基準を作って運用することもあります。

物体検出の精度指標

物体検出では、「対象をどれだけ正確に検出できたか」と「その位置が合っているか」を評価します。

代表的な指標

IoU(Intersection over Union)

AIが出した枠と、正解の枠がどれだけ重なっているか。

完全に一致するとIoUは1.0となり、0.5以上なら“検出成功”とみなすケースが多い。

mAP(mean Average Precision)

検出成功と判定された枠のうち、どのくらいが実際に正確だったかの平均スコア。

検出タスク全体を通じた総合的な性能を見る指標。

IoUは“どのくらい正しく囲えているか”、mAPは“全体的にどのくらい取りこぼしていないか”を示します。そして、部品の検出において「半分だけ映っているのを検出できなかった」「ゴミを部品と誤認した」など、ミスの種類に応じて評価が分かれるのが物体検出の難しさでもあります。

さらに他の指標についても、過去の記事「AIの精度は一つじゃない?精度の評価指標をご紹介」でご紹介しているので、ぜひご覧ください。

「100%」の精度って目指せるの?

結論から言えば、100%の精度はほぼ不可能です。

照明のちょっとした変化やカメラのブレ、対象物のゆらぎなど、現場には不確実性がつきものです。

そのため、AIを評価する際は、たとえば

OCR:8文字中1文字までの誤りならOK?

物体検出:1割の見逃しならライン停止しない?

というように、「どこまでの誤差なら許容できるか」を定めておくことが重要です。

業務への影響度と、現場の許容範囲をすり合わせることが、精度以上に大切なのです。

次章では、こうした精度の考え方を踏まえたうえで、現場のニーズに応じた“技術の選び方”について具体的に解説していきます。

現場ニーズから考える「OCRか物体検出か」の選び方

ここからは、具体的なユースケースをもとに、「OCR」「物体検出」どちらが適しているかを判断するためのヒントを紹介します。現場の視点から、“何をAIに判断させたいのか?”を考えるのが最も重要なポイントです。

パターン①:ラベルの文字を読みたい

例:部品に貼られたシールに記載された品番や日付を読み取りたい

→ OCRが適任。

必要な出力は“テキスト”

シールがきちんと貼られてさえいればOKで、その位置や傾き等にばらつきがあっても問題はない

ただし、照明によって反射・かすれが生じると読みにくくなるので注意

照明の工夫や、レイアウト認識(文字の配置)の補正機能なども、精度を上げるカギとなります。

パターン②:部品があるかどうかを確認したい

例:組立工程後、特定の部品が正しく装着されているかを検出したい

→ 物体検出が適任。

必要なのは“存在の有無と位置”

正しい位置に対象物がない、ズレている、向きがおかしい——といった異常も拾える

多数個を一括で見られる

逆に、部品に記載されている文字までは読み取れません。判断対象は“形”と“場所”です。

パターン③:「ラベルが貼ってあるかどうか、そのうえで内容も確認したい」

例:ラベルが貼付されているかを確認し、さらに品番を読み取りたい

→ 物体検出+OCRの併用が有効。

最初に物体検出でラベルの有無を確認し、あればその位置を切り出してOCRに渡す

“そこにラベルがあるか”と“ラベルに何と書いてあるか”は別物。別々の技術で分担したほうが精度が高い

パターン④:異物混入や欠陥を見つけたい

例:黒い異物が混ざっていないか? 傷や変形がないか?

→ 物体検出またはセグメンテーション技術が適しています。

OCRでは対象が“文字”でないため検出できません。形や色の違いを捉えるには、物体検出や画像分類、場合によってはセグメンテーション(画素単位の分類)を組み合わせた構成が必要になります。

パターン⑤:レーザーマーキングのかすれた品番

金属部品に刻印された品番が浅く、OCRでは読めないケースも。内容が読めないが、位置や形でおおよその部品を識別できるなら、物体検出で代替が可能な場合もあります。

OCR:文字認識前提のため、かすれや反射に弱い

物体検出:ラベルの場所・形・特徴を「物」として捉えることで、簡易的な判断は可能

パターン⑥:ラベルが貼られている“位置の正しさ”を検査したい

内容よりも「どこに貼られているか?」が重要な場合。

位置をチェックするだけなら物体検出で充分

ただし、「そのラベルの内容が正しいかどうか」まで見るならOCRも必要になる

パターン⑦:2次元コードの“存在確認”だけしたい

2次元コードの中身は読まずに「ちゃんと貼られているか」を見たいだけ。

物体検出で2次元コードの位置を検出するだけでも成立

ただし、今後読み取りが必要になるならOCRや専用リーダー導入も視野に

迷ったときの判断基準:「出力の形式」に注目

テキストが欲しい → OCR

画像内の“どこにあるか”を知りたい → 物体検出

現場でありがちなのは、“目視で何を確認していたか”だけを頼りにAIを選んでしまうことです。しかし、AIにやらせる以上は「何を出力させたいか」に着目することが大切です。

次章では、こうしたモデル選定の先にある「導入・運用の工夫」について紹介していきます。

導入・運用の勘どころ(照明・エッジ vs サーバなど)

「AIモデルを選んだから、あとは動かすだけ」——そんなふうに思っていたのに、実際には思ったように精度が出なかった……。

そんなケースでよく見落とされているのが、「AIを動かす周辺環境」の重要性です。

この章では、モデル選定のあとで差がつく導入・運用時の工夫ポイントを、TechSword Visionの知見も交えて紹介していきます。

ポイント①:照明は“AIの眼鏡”になる

画像認識AIにとって、照明はまさに“眼鏡”です。

光が強すぎると、白飛びして文字や輪郭が消える

弱すぎると、ノイズが増えて識別不能に

金属面や透明素材は反射・映り込みが起こりやすい

このため、照明設計では「どこから、どの色温度で、どの角度から」当てるかが重要です。ドーム照明や偏光フィルターなどを活用することで、検出精度が格段に変わるケースもあります。 (参考: AI検査がうまくいかない原因、「照明」かもしれません)

ポイント②:処理環境の選定(エッジ or サーバ)

AIをどこで動かすかによって、システム全体の構成や使い勝手が大きく変わります。

エッジ処理(例:Jetsonなど)

エッジ処理とは、学習済みAIモデルを備え付けたデバイスを現場に設置する方法です。

撮ってすぐに判断でき、リアルタイム性に優れる

オフラインでも動作でき、ネットワークに依存しない

ただし、複雑なAIモデルは処理能力に制限あり

サーバ処理(クラウドやオンプレ)

サーバ処理とは、現場から離れたコンピュータにデータを送り、そこでAIが判断する方法です。

モデルサイズの制限がなく、高性能なAIも実行できる

ログや画像を蓄積しやすい

通信トラブル時は止まるリスクあり

現場の通信環境・処理スピード・ログ管理の必要性に応じて、処理環境を整えましょう。 (参考: エッジでAIを動かすと何がいいの?デメリットもご紹介)

ポイント③:誰が運用するのか?を最初に決める

AIモデルそのものよりも、「誰が見るか・触るか」 で運用のしやすさは大きく変わります。

ノーコードツールを採用し、現場で働く従業員が直接扱えるようにするか?

メンテナンスは開発部門が担うか?

外注する場合、どこまで委託するか?

運用者が“ブラックボックス扱い”してしまうと、ちょっとした異常にも気づくのが難しくなてしまいます。

TechSword Visionでは、現場でも使えるUIや、検出履歴の蓄積、再学習用画像の自動収集によって、「使いながら育てる」仕組みを支援しています。

まとめ

この記事では、画像認識AIの代表格である「OCR(文字認識)」と「物体検出(Object Detection)」の違いを軸に、導入検討や運用でのヒントを現場目線でお伝えしてきました。

あらためて、要点を振り返ってみましょう。

OCRと物体検出の違い:要点まとめ

比較項目 | OCR | 物体検出 |

|---|---|---|

認識対象 | 文字 | モノ(物体・領域) |

出力形式 | テキスト | 座標・ラベル付き検出結果 |

得意な用途 | 品番・日付の読み取り | 部品有無、異物検知、配置ミス |

苦手なケース | 傾き・かすれ・反射 | 小さな文字、細かい表記識別 |

また、「テキストが欲しいのか?」「位置を知りたいのか?」という出力形式の違いに注目することで、迷ったときの判断軸が明確になります。

さらに、以下のような“導入時の勘どころ”も成功の鍵となります。

照明はAIの眼鏡

エッジ vs サーバの選定は通信環境とスピードがカギ

「誰が使うか?」の設計から始める

まずは「何を出力させたいか?」を考える

AIを導入するかどうかよりも前に、まず考えるべきなのは、

AIに“何を出力させたいか?”

それがテキストであればOCR、位置や存在の有無であれば物体検出。

そして、条件次第ではその2つの併用、あるいは別の技術も選択肢に入ってくるかもしれません。

その判断をサポートするために、私たちTechSwordは現場目線の提案を続けていきます。

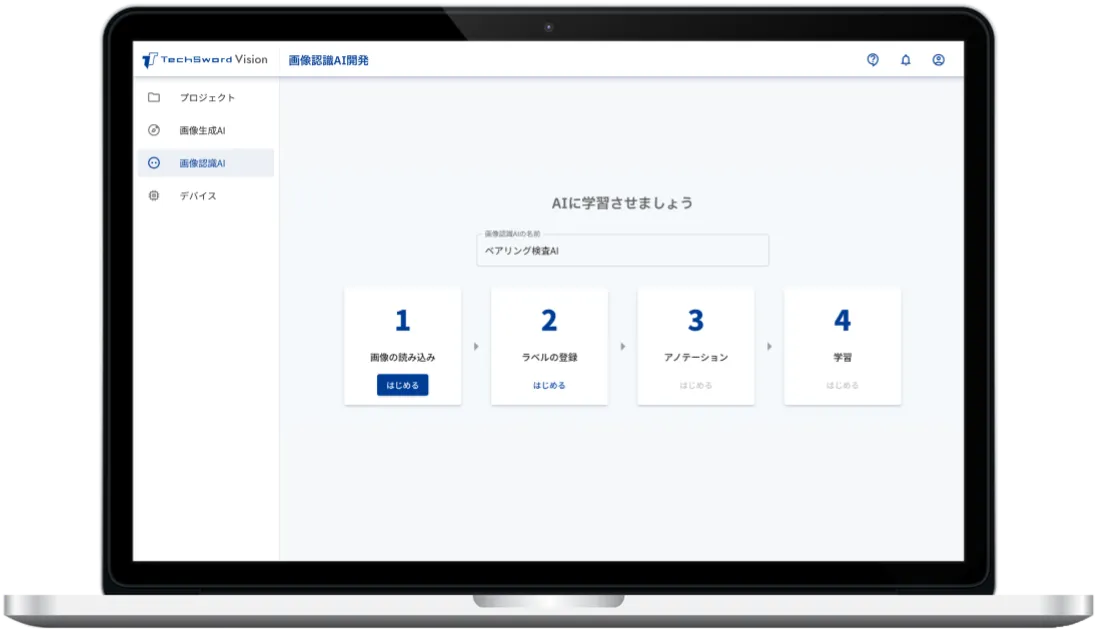

TechSword Vision のご紹介

TechSword Vision は、ノーコードで画像認識AIを作成・運用できるプラットフォームです。

現場で撮った画像から学習データを作成

ノーコードで物体検出モデルを構築・評価

エッジデバイスへのデプロイも簡単

「AIは難しそう」「自社では無理かも」と思っていた現場でも、すぐに試すことができ、すぐに改善を始められます。

ご興味がある場合は、ぜひ詳細なサービス説明資料をご請求ください。

また、具体的な導入事例や導入後の流れについても、ご希望に応じて説明させて頂きます。ぜひお気軽にお問い合わせください。